초록

위성 원격 감지 또는 바이로버 온보드 센서에 의해 수집된 지형 이미지는 유성 로버의 지형 통과성 및 임무 계획을 결정하는 데 사용되는 지형 분류의 주요 출처이다. 지형 클래스를 위한 RGB와 IR 사이의 매핑 모델은 동일하거나 유사한 지형의 실제 RGB 및 IR 데이터 예에서 학습된다. 본 논문은 MU-Net(Multiple U-Net)이라는 새로운 클래스의 딥 러닝 아키텍처를 추가하고 더 나은 RGB-to-IR 매핑 모델을 도출하는 효율성을 보여주며, 들어오는 RGB 영상 및 학습된 RGB-IR 매핑에서 열 IR 영상의 추정을 과거 작업에 비해 향상시켰다.

1. 서론

지형 분류는 화성 탐사 로봇에 대한 자율 항행을 위한 핵심 구성 요소 중 하나이다. RGB와 열적외선(IR) 영상을 모두 사용하여 RGB를 사용하는 것에 비해 지형 분류 성능을 향상시키는 지형 분류 시스템이 [1]에서 제안되었다. 그러나 미래의 탐사 로봇에는 IR 카메라가 있지만, 화성 과학 연구소(MSL)나 화성 2020[2]에는 RGB 카메라에만 의존하는 IR 카메라가 없다. 이러한 부재를 피하기 위한 가능한 방법은 RGB와 IR 모두에서 보이는 이미지의 예에서 학습한 IR의 추정치를 실제 IR 대신 사용하는 것이다. 이러한 예에서 학습한 내용은 [3]에 설명된 새로운 딥 러닝 기법을 통해 확인할 수 있다. 그림 1 (a)와 (b)는 각각 RGB 카메라와 IR 카메라가 있는 이미지의 예를 보여주고, 그림 1 (c)는 [3]에서 제안된 UNet 기반 방법에 기초하여 그림 1 (a)의 추정 IR 이미지를 보여준다. 본 논문에서 소개된 새로운 학습 아키텍처 세트는 그림 1(d)에 표시된 것처럼 학습된 모델과 IR 추정을 개선한다(그림 1(a)와 같이 학습된 매핑 및 입력 RGB에서 도출된다.

아직까지는 제한적이지만 실험 결과는 적어도 구성 요소의 다양성이 상대적으로 낮은 행성 표면(다양한 암석 및 모래)과 유사한 지형의 제한적이고 제한된 조건에서 RGB 도메인에서 IR 도메인을 추정할 수 있는 것처럼 보인다는 것을 보여준다. (그리고 자율 주행과 과학에 매우 유용할 수 있다.)

주어진 조건에서 RGB의 IR 추정에 대한 이 첫 번째 고무적인 결과에 대한 한 가지 가능한 설명은 이미징된 물체의 에너지 교환 균형과 관련이 있을 수 있다. 짧은 시간 동안, 표면 물체에 의해 방출되는 에너지는 흡수된 에너지와 거의 같습니다. 낮에 들어오는 에너지는 알려진 스펙트럼을 가진 태양으로부터 나오며, 일부는 반사되어 RGB/시각으로 관측 가능한 부분을 포함하며 일부는 흡수된다. 이는 반사된 것과 거의 같다(불투명한 물체라고 가정한다. 방출되는 에너지는 물질의 방출과 온도에 따라 달라집니다. 방사성은 물질의 종류와 파장에 따라 달라진다. 낮에 온도는 주로 표면에 정상적으로 부딪히는 에너지의 양(즉, 태양에 대한 표면의 각도)과 열 관성(온도의 변화에 저항하는 물질의 능력을 나타내는 척도)에 의해 결정된다. 지형별로 경사각 차이가 작은 경우 각 지형의 온도는 열 관성에 의해 좌우된다. 따라서 열 관성을 통해 터레인 유형이 지형 온도에 영향을 미치므로 열 IR 정보를 제공한다.

이전 연구는 RGB에서 IR을 추정하는 것의 실현 가능성을 나타내었지만, 성능은 보통이었다[3]. 이론적인 해석이 시도되지 않았고 모델에 지형 유형 정보를 통합하려고 시도하지 않았다.

본 논문은 먼저 RGB 이미지에서 IR 영상의 추정 결과를 지원할 수 있는 이론적 설명을 시도한다. 지형 유형 정보를 고려한 새로운 딥 러닝 아키텍처 세트가 도입된다. MU-Net(Multiple U-Net에서)이라는 이름의 새로운 아키텍처 세트는 U-Net[4]을 기반으로 하며, 의료 영상 분할[5]에서 널리 사용되며 위성 영상 분할 경쟁(Kaggle 경쟁[6])에서도 사용되었다. MU-Net은 열 IR 정보와 더불어 지형 유형 정보를 추정하도록 설계되었습니다. 이를 통해 열 IR 정보를 추정하기 위한 지레인 유형의 정보를 암묵적으로 그리고 명시적으로 포함시킬 수 있으며, 이는 단일 센서 입력(RGB 카메라)의 IR 이미지열 추정을 개선한다.

RGB의 IR 추정([3]을 제외한 다른 작업은 인식하지 못함)과 작업 본체가 존재하는 그레이 스케일 이미지의 색상화 사이에는 유사성이 있다[7] [8] [9]. 일반적으로 이러한 방법은 휘도가 그레이스케일 영상에 제공되기 때문에 색도 추정이 필요하다. Iizuka 등은 그레이 스케일 이미지에서 색조 값을 직접 추정하기 위해 심층 컨볼루션 신경망(딥 CNN)을 제안했다[11]. 라르손 외 [12]와 장 외 [13] 사전 훈련된 네트워크를 사용하여 네트워크를 초기화했다. 림머 등은 색도 및 휘도 추정이 필요한 근접 IR 영상을 컬러화하는 CNN 기반 방법을 제안했다[10].

심층 신경망 학습에는 대규모 데이터 세트가 필요하다. 예를 들어 방금 인용한 [10]에서는 거의 38,495개의 이미지 쌍이 사용된다. 사용 가능한 교육 데이터가 충분하지 않으면 ImageNet[14]과 같은 공개 데이터 세트를 사용하여 사전 훈련된 매개 변수를 사용할 수 있다. 그러나 공개 데이터 세트에는 일반적으로 자동차, 인간, 볼 등과 같이 클래스 간 변동이 큰 이미지가 포함되므로 사전 훈련된 매개 변수는 클래스 간 변동이 공개 데이터 세트보다 훨씬 작은 지형 유형의 특징을 효율적으로 설명하지 않는다. 반면에, 더 작은 데이터 세트를 사용하는 훈련은 U-net을 통해 실현 가능할 수 있다.

2. 방법론

이 절에서는 먼저 RGB 이미지에서 IR 이미지를 추정할 수 있는 이유에 대한 가능한 이론적 설명을 제공한다. 그런 다음 열 IR 정보를 추정하는 U-net 방법[3]이 설명되고 제안된 MU-Net이 설명된다.

RGB 카메라는 약 390 - 700 [nm]의 파장에 반응하는 반면 열 카메라는 7-14 [μm]의 장파 IR과 같은 다양한 파장에 반응한다. 일반적으로 한 스펙트럼 영역의 정보는 다른 스펙트럼 영역의 정보에 의해 확실히 결정될 수 없다. 그러나, 특정 가정하에서, 특히 (i) 메이트리알은 불투명하고, (ii) 사건은 즉시 발생하며, (iii) 복사 선원은 태양일 뿐이며, 우리는 RGB 도메인에서 IR 도메인의 표현을 추정할 수 있다.

불투명한 물질의 경우 입사 에너지 I은 반사 에너지 R과 흡수 에너지 A를 I=R+A로 정의한다. 물질이 평형을 유지하려면 흡수된 에너지가 방출 에너지 E(E=A)와 같아야 한다. (더 정확하게 말하면, 우리는 에너지를 짧은 시간 동안 사용하므로 효과적으로 전력을 참조한다.) 따라서 첫 번째 방정식은 I=R+E가 된다. 여기서, 우리는 RGB 이미지 캡처 리플렉션R을 재료에서, IR 이미지에서는 방출E를 캡처한다고 가정할 수 있다. IR 영상에서 관찰된 방출 에너지는 이제 E=I-R로 정의됩니다. 입사 I의 주요 파라미터는 태양에 대한 각도이며, 파라미터는 태양의 각도 및 기하학적 정보에 기초하여 보정될 수 있다. 단순화된 가정에서는 태양에 대한 각도가 균일하다고 가정할 수 있다(즉, 입사 I은 전체 영역에서 일정하다). (수신/반사 표면의 각도는 모든 관심 영역에서 동일하다는 의미)이러한 가정은 너무 강하며 드문 경우를 제외하고 유지되지 않으므로 품질이 없습니다. 그러나 일부 관계가 존재하므로 추정치는 제한적이지만 잠재적으로 유용하다.

U-Net[4]의 아키텍처는 그림 2에 나타나 있으며, 계약 경로(왼쪽)와 확장 경로(오른쪽)로 구성되어 있다. 각 경로에는 반복되는 단위가 있습니다. 청색 직사각형으로 표시된 것처럼 수축 경로의 단위(계약 단위)는 두 개의 3×3 컨볼루션으로 구성되며, 그 뒤에 정류 선형 단위(ReLU)와 2×2 최대 풀링이 뒤따른다. 확장 경로에는 두 개의 다른 장치가 있습니다.빨간색 직사각형으로 표시된 첫 번째 (확장 단위 1)는 두 개의 3×3 컨볼루션으로 구성되며, 각각 ReLU, 2×2 디콘볼루션, 그리고 디콘볼루션 계층과 계약 경로의 콘볼루션 계층 양쪽에서 나오는 출력의 결합이다. 또 다른 단위(확장 단위 2)는 주황색 직사각형으로 표시된 것처럼 확장 경로의 마지막 단위이며, 두 개의 3×3 컨볼루션이 있고, 그 다음에는 수정 선형 단위(ReLU)가 있다. 여기서, 확장 단위 1에서, 이진 업샘플은 수축 경로에서 콘볼루션 레이어의 출력에 적용된다. 이 연결 계층은 소수의 데이터 세트로 네트워크를 훈련할 수 있는 U-Net의 주요 아이디어 중 하나이다. 마지막 레이어에서 1×1 컨볼루션(convolution)이 적용되어 각 픽셀의 64 채널 정보를 클래스 수(N)에 매핑한다.모든 아키텍처의 손실 함수 LCE는 다음과 같이 정의된 대로 최종 맵에 대한 픽셀 단위 소프트-최대값으로 정의되고, 이어서 교차 엔트로피 손실 함수로 정의된다.

여기서 N,|S|,yj,pij는 각각 클래스 수, 이미지 S에 대한 총 픽셀 수, 각 픽셀에서의 실제 분포 및 각 픽셀의 출력 확률 분포이다. 손실 함수는 확률적 경사 하강법에 의해 최소화된다.

RGB 영상에서 열 IR 영상을 합성하기 위해 그림 2에 열 IR 영상으로 출력 주석을 배치했다. 평균 제곱 오차(MSE) LMSE를 손실 함수로 사용했는데, 이는 다음과 같이 정의됩니다.

여기서 C는 채널의 수이고, aij 및 bij는 각각 접지 열 이미지 a와 출력 열 이미지 b의 각 픽셀(i, j)의 열 값이다. 이 모델은 RGB 영상으로 네트워크를 직접 훈련시키고 열 IR 영상 추정을 개선할 수 있는 지형형 정보를 고려하지 않는다.

지형 유형 정보를 고려하여 MU-Net(Multiple U-Net)을 제안합니다. 제안된 MU-Net은 (i) MU-Net1과 (ii) MU-Net2의 두 가지 범주로, 명시적으로 모델에 지형 유형 정보를 포함한다.

MU-Net1은 IR 열 영상과 주석 영상을 모두 출력하도록 설계되어 훈련된 모델에 IR과 주석 정보가 모두 포함된다. MU-Net1은 그림 3과 같이 두 개의 아키텍처를 가지고 있다. 첫 번째, MU-Net1-a는 U-Net과 동일한 아키텍처이지만, MU-Net1-a는 주석과 IR 열 이미지의 두 가지 출력을 가지고 있다. 따라서 이 모델에서는 두 가지 손실 함수가 있습니다.LCE와 LMSE를 가중 손실 함수로 결합하였다.

여기서, λ는 경험적으로 200의 값을 할당 받는다. MU-Net1-a 모델은 IR 열 및 주석 이미지의 손실 기능을 모두 최소화하는 방식으로 훈련된다. 두 번째 아키텍처는 그림 3 (b)와 같이 MU-Net1-b이며, 이 아키텍처는 각 IR 열 및 주석 이미지에 대한 확장 단위를 가지고 있다. 그 이유는 다음과 같다. IR 열 영상과 주석 영상은 근본적으로 다른 영상을 보여주므로 MU-Net1-a는 이 두 영상을 공통 확장 단위로 모델링하지 못할 수 있다. MU-Net1-b에서는 가중 손실 함수 Eq. 3도 사용한다.

MU-Net2는 지형 유형 정보를 아키텍처에 명시적으로 포함하도록 설계되었습니다(그림 4와 5). MU-Net2는 그림 4와 5의 점회색 직사각형에 표시된 주석 이미지를 위한 독립적인 아키텍처를 가지고 있다. 주석 이미지에 대한 모델은 먼저 훈련되고 훈련된 매개 변수는 IR 열 이미지의 아키텍처로 복사된다. 우리는 또한 MU-Net2를 위한 두 가지 아키텍처도 있다. 첫 번째 MU-Net2-a(그림.4)는 두 개의 서로 다른 수축 단위(a)와 (b)를 가지며, 수축 단위(b)는 주석 이미지의 모델에서 복사한 것입니다. 두 수축 단위의 출력은 연결되고 확장 단위 1(a)에 대한 입력으로 사용된다. 계약 단위(b)에 대한 역전이 없다. 두 번째 아키텍처인 MU-Net2-b(그림 5)는 그림 5의 점선 회색 직사각형에 주석 이미지를 위해 수축 단위(b)와 모델의 확장 단위(b) 1(b) 및 2(b)의 매개변수를 복사한다. 확장 단위 2(b)의 출력은 픽셀-셔플 기법으로 축소되며, 수축 단위 (a)의 출력과 연결됩니다. 마지막으로, 확장 단위 1(a)에 대한 입력으로 사용됩니다. MU-Net2-a와 MU-Net2-b 모두 IR 영상의 손실 함수로 LMSE만 사용한다.

3. 실험

이 섹션에서는 먼저 가시적 이미지와 열적 이미지를 포함하는 데이터 세트에 대해 설명한 후 데이터 세트에 대한 실험적인 결과를 설명한다.

우리는 [3]의 동일한 데이터 세트를 훈련에 사용하고 성능 평가를 위해 더 많은 데이터 세트를 추가했다. 2017년 11월 17일 오전 10시부터 오후 5시까지 RGB 카메라(FLIR Grasshopper 5M)와 열 카메라(FLIRAX65)가 있는 지역(JPL Mars Yard)에서 영상이 수집되었다. RGB와 IR 영상은 1시간마다 수집됐으며, 카메라 위치를 바꿔 매번 52개의 영상이 수집됐다(8시간 동안 총 416개의 영상 쌍). 그림 6은 캡처된 이미지 쌍의 예를 보여줍니다. 모래 지역은 열 관성이 낮기 때문에 온도가 낮은 경향이 있다. 반면에, 암석 지역은 더 높은 열 관성을 가지고 있기 때문에 더 높은 온도를 보인다. 가시영상과 열영상 촬영은 카메라가 다르기 때문에 카메라 간 등록 절차가 필요하다. 추정된 카메라 내부 매개 변수로 왜곡을 제거한 후 추정된 호모그래피 매트릭스를 사용하여 아핀 변환을 적용했다.

다음 실험에서는 RGB 및 IR 영상의 50%를 갤러리 데이터로, 25%를 매개 변수를 결정하기 위한 평가에 사용했다. 성능 평가에는 두 가지 설정이 있습니다. (i) 시험의 나머지 25%는 오후 5시에, 그리고 (ii) 시험을 위해 오전 10시부터 오후 5시까지 1시간마다 촬영된 이미지입니다. 지형 분류에 대해서는 6가지 지형 유형(토양, 모래, 바위, 암반, 바위 지형, 밸러스트)으로 구분했습니다. 각 지형 유형의 데이터 크기가 균형적이지 않기 때문에 MSE와 교차 엔트로피 손실에 가중치를 도입했다. 여기서는 각 지형이 IR 영상에 대해 고유한 온도를 가지며, 음영이나 기울기와 같은 온도를 변경하는 다른 요인은 무시한다는 가정입니다.각 지형 유형의 가중치는 훈련 데이터 세트에서 픽셀 수 비율의 제곱근으로 정의된다. 그림 7 (a)에 표시된 주석 영상은 수동으로 미리 설정됩니다.

첫 번째 실험에서, 우리는 지형 유형 정보를 모델에 암시적으로 활용하는 제안된 MU-Net1과 모델에 명시적으로 지형 유형 정보를 활용하는 제안된 MU-Net2를 데이터 세트에 적용했다. 그림 7 (a)~(e)는 캡처된 이미지, 수동 주석이 달린 이미지, MU-Net1-a의 추정 주석 이미지, MU-Net1-b의 주석 이미지 및 MU-Net2의 예를 각각 보여준다. MU-Net1-a에 의한 추정 지형 유형에는 MU-Net1-a에 의한 유형보다 더 많은 거짓 양성 반응이 포함되는 경향이 있다. 예를 들어 MU-Net1-a(그림 7 (c))에 의해 추정된 암석은 토양으로 잘못 분류된다. 이는 각 열 IR 영상과 주석 영상에 대한 확장 장치가 효과적으로 작동함을 시사한다. 그림 7(e)의 MU-Net2에 의한 추정 지형 유형에는 MU-Net1(그림 7(c) 및 (d)보다 더 많은 거짓 양성이 포함되어 있습니다. 그림 7(c)~(e)의 밑그림에 따르면 밸러스트 영역(빨간색 영역)은 토양 영역(갈색 영역)으로 잘못 분류되지만, 이 영역은 토양과 밸러스트 영역이 혼재되어 있어 사람조차 분류하기 어렵다.

RGB 영상에서 추정된 IR 영상에 대해서는 먼저 표와 같이 정량적 평가를 보여준다. 섹션 2에서 언급했듯이, 추정된 IR 값은 실제 값의 스케일링된 값입니다. 지상 실측 IR 값Eg(x, y)와 추정 IR 값Eee(x, y)를 직접 비교할 수 없으므로 표준 편차와 평균을 바탕으로 값을 다음과 같이 정규화한다. Eμg(x, y)=(Eg(x, y)-μg)/μg(x, y)=(Eee(x, y)-μe)/μe, 여기서 μg, μg, μe 및 μe는 IR의 지상 실측 정보 평균과 표준편차 및 추정 IR 영상의 평균 및 표준 편차입니다. 정규화된 IR 영상의 지상 실측정보와 정규화된 추정 IR 영상, 평균 절대 오차(MAE)가 각 접근 방식에 대해 계산됩니다. MU-Net1-b는 모든 모델 중 가장 작은 오차를 보여준다.

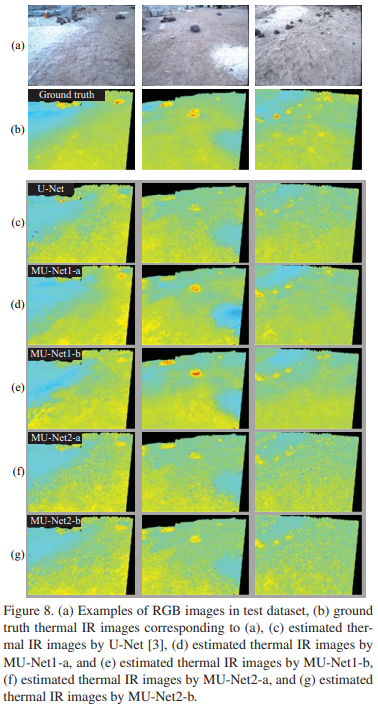

또한 정규화된 영상을 사용하여 그림 8에 표시된 것과 같이 E′′g(x, y)=(E′g(x, y)*σg+ 128) and E′′e(x, y)=(E′e(x, y)*σg+ 128)의 예제를 시각화했다. 그림 8(a), (b), (d), (e)는 각각 캡처된 이미지, (a)에 해당하는 접지 진실 IR 열 이미지, MU-Net1-a의 추정 IR 열 이미지 및 MU-Net1-b의 예제를 보여준다. 또한 제안된 MU-Net1을 그림 8(c)에 표시된 [3]과 비교했다.MU-Net1-b의 결과는 [3]의 결과보다 매끄러운 결과를 보여준다. 이러한 결과는 또한 MU-Net1-b의 성능이 U-Net 및 MU-Net1-a의 성능보다 우수하다는 것을 시사한다.그림 8 (f)와 (g)는 MU-Net2-a 및 MU-Net2-b에 의한 추정 열 IR 영상을 보여주며, 이러한 결과는 MU-Net1-b의 결과보다 더 많은 잘못된 긍정을 보여준다. E′g와 E′e에 기반한 MU-Net1-a의 MAE는 2.30도이다.

위의 결과에서, MU-Net1-a와 MU-Net1-b는 MU-Net2-a와 MU-Net2-b보다 성능이 우수하다. MU-Net1이 더 나은 이유 중 하나는 다음과 같다. MU-Net2에서 주석(어노테이션) 이미지 모델은 주석 이미지만으로 훈련된다. 반면, MU-Net1은 주석과 열 IR 이미지를 모두 사용하여 네트워크를 훈련시킨다. MU-Net1에서 IR 영상을 사용하면 주석 영상의 분류 성능을 향상시키는 추가 제약 조건을 얻을 수 있다. 따라서 MU-Net1에서 열 IR 영상의 추정이 개선됩니다.

다음 실험에서, 우리는 오전 10시부터 오후 5시까지 1시간마다 찍은 이미지를 프로브 데이터 세트로 사용하여 오후 5시에 이미지로 훈련된 모델이 시간 변동에서 강력한지 확인했다. 오후 5시 영상의 실험 설정에 대해서는 이전 섹션과 동일한 설정(즉, 갤러리, 평가 및 테스트 데이터 세트 간 중복 없음)을 사용했다. 그림 9는 오전 10시부터 오후 5시까지 MU-Net1-a, MU-Net1-b, MU-Net2-b의 MAE를 보여주고 있다. 이러한 결과는 MU-Net1-b가 다섯 가지 아키텍처 중 가장 강력한 아키텍처임을 보여준다.

그림 10(a)는 오전 10시부터 오후 4시까지 캡처된 RGB 영상을 보여주고, 그림 10(b) 및 (c)는 MU-Net1-b에 의한 (a) 및 추정 열 IR 영상에 해당하는 지상 실측 IR 영상을 보여준다. 이러한 이미지는 제안된 방법에 의해 전반적인 온도 특성이 예측된다는 것을 보여주지만 제안된 방법은 그림자, 태양의 각도, 지질 정보 등을 고려하지 않기 때문에 지상 실측 IR 영상과 추정 IR 영상 간의 차이를 볼 수 있다. 이것들은 향후 작업을 위해 남겨졌다.

4. 결론

본 논문에서 우리는 RGB 이미지에서 열 IR 이미지를 추정하기 위해 지형 유형 정보를 사용할 것을 제안했다.우리는 MU-Net1-a, MU-Net1-b, MU-Net2-a 및 MU-Net2-b라는 네 가지 딥 러닝 아키텍처를 소개했다.MU-Net1-b는 모델을 훈련시키기 위해 열 IR 영상 외에 주석 영상을 제약 조건으로 사용하는 장점을 취하기 때문에 최고의 성능을 보여주었다. 열 관성, 태양으로 향하는 방향, 지질 상태 등 지형 표면의 온도를 결정하는 많은 매개 변수가 있습니다. 향후 작업에서는 이러한 매개 변수를 모형에 포함할 것입니다.

5. 인정

이 연구는 미국항공우주국(na)의 계약에 따라 미국 캘리포니아 공과대학 제트추진연구소에서 수행됐다.

References

[1] Y. Iwashita, K. Nakashima, A. Stoica, R. Kurazume, TUNet and TDeepLab: Deep Learning-based Terrain Classification Robust to Illumination Changes, Combining Visible and Thermal Imagery, IEEE Int. Conf. on Multimedia Information Processing and Retrieval 2019, accepted.

[2] Mars Science Laboratory (MSL), https://mars.nasa.gov/msl/

[3] Y. Iwashita, A. Stoica, K. Nakashima, Virtual sensors determined through machine learning, World Automation Congress (WAC) 2018.

[4] O. Ronneberger, P. Fischer, and T. Brox, U-Net: Convolutional Networks for Biomedical Image Segmentation, MICCAI 2015.

[5] O. Cicek, A. Abdulkadir, S.S. Lienkamp, T. Brox, O. Ronneberger, 3D U-Net: Learning Dense Volumetric Segmentation from Sparse Annotation, MICCAI 2016.

[6] Dstl Satellite Imagery Feature Detection, https://www.kaggle.com/c/dstl-satellite-imagery-featuredetection

[7] Z. Cheng, Q. Yang, and B. Sheng, Deep colorization, Proc. International Conference on Computer Vision ,2015.

[8] G. Patterson and J. Hays, Sun attribute database: Discovering, annotating, and recognizing scene attributes, Proc. Conference on Computer Vision and Pattern Recognition, 2012.

[9] E. Tola, V. Lepetit, and P. Fua, A fast local descriptor for dense matching, Proc. Conference on Computer Vision and Pattern Recognition, 2008.

[10] M. Limmer, and H. Lensch Infrared Colorization Using Deep Convolutional Neural Networks, IEEE Int. Conf. on Machine Learning and Applications (ICMLA), 2016.

[11] S. Iizuka, E. Simo-Serra, and H. Ishikawa, Let there be color!: Joint end-to-end learning of global and local image priors for automatic image colorization with simultaneous classification, Proc. ACM SIGGRAPH, vol. 35, no. 4, 2016. [12] G. Larsson, M. Maire, and G. Shakhnarovich, Learning representations for automatic colorization, arXiv:1603.06668, 2016.

[13] R. Zhang, P. Isola, and A. A. Efros, Colorful image colorization, arXiv:1603.08511, 2016.

[14] J. Den, W. Dong, R. Socher, and F. Li, ImageNet: a LargeScale Hierarchical Image Database, CVPR 2009.

'프로그래밍 > 논문 번역' 카테고리의 다른 글

| Deep Convolutional Neural Network-based Fusion of RGB and IR Images in Marine Environment 번역 (0) | 2021.05.11 |

|---|---|

| 논문 번역 AUTOMATIC PARKING OF SELF-DRIVING CAR BASED ON LIDAR (0) | 2021.05.06 |

댓글